Les cartésiens considèrent que l’on peut tout expliquer et tout démontrer par l’analyse scientifique. S’il est bien un domaine du management où l’on aimerait pouvoir appliquer cette approche, c’est celui de la décision en entreprise. Une abondante littérature y est consacrée et sa place dans les programmes est importante.

L’enseignement de la décision est marqué par une approche plutôt procédurale visant à expliquer comment on décide. Les étudiants la résument parfois de manière simpliste et mnémotechnique au fameux modèle « IMC » (intelligence/modélisation/choix) rendu célèbre par Simon. La règle quatrième de Descartes précise que « la méthode est la voie que l’esprit doit suivre pour atteindre la vérité ». Cependant, l’histoire managériale est traversée de cas d’erreurs d’appréciation et de décisions fâcheuses pour des entreprises. Comment un groupe comme Kodak a-t-il pu ignorer le développement du numérique ? Pourquoi certains dirigeants, appuyés par des conseils d’administrations et conseillés par des armées de consultants et d’experts, ignorent-ils à ce point certaines opportunités ou prennent-ils des décisions aussi fâcheuses et dramatiques ? Dans l’affaire du sang contaminé, alors que le risque était connu dès 1983, les prélèvements de sang sur les sujets à risque augmentèrent en 1984 et le stock de poches à risque est resté sur le marché et remboursé jusqu’en 1985, causant la contamination d’un utilisateur sur deux ! Cette affaire qui a défrayé (à retardement) la chronique illustre bien les errements de la prise de décision et l’absence de logique (puisqu’on connaissait le risque). De nombreux exemples dramatiques existent (explosion en vol de la navette Challenger, incendie du tunnel du Mont Blanc...), aux conséquences humaines lourdes ; mais les entreprises sont confrontées tous les jours à une multitude de décisions à prendre, dans un monde de moins en moins « lisibles » où l’incertitude devient la règle. La quasi-disparition des services de planification l’illustre et rend perplexe les analystes.

Un paradoxe important apparait alors : dans un monde où la rationalité est érigée en modèle, il faut décider de plus en plus vite avec un flux d’informations qui semble de plus en plus important (multiplication des sources à l’époque d’Internet). Il semble donc de plus en plus difficile de décider et les méthodologies issues des théories de la décision paraissent souvent inopérantes. Carlos Goshn a expliqué en 2003, lors de sa mission de reprise de Nissan, que le fait de ne pas être japonais lui avait permis de décider en se libérant de certaines contraintes. Les résultats pour Nissan furent spectaculaires...

Alain Berthoz, professeur au collège de France résume ainsi le paradoxe : « Nous sortons d’un siècle où domina l’illusion que l’homme est rationnel, alors qu’en fait les obscurantismes, la violence, mais aussi des effets divers notamment la panique sociale, n’ont fait que démontrer les forces de l’irrationnel et, en particulier, de l’émotion ».

Ainsi la problématique actuelle pourrait être la suivante : « comment décider dans un monde de plus en plus incertain et complexe ? »

Il convient donc de revenir sur l’hypothèse de la rationalité dans la décision (1) et d’en montrer les limites, avant de mettre en lumière quelques approches composites et alternatives, principalement l’école politique de la décision et le modèle de la poubelle (2), elles aussi limitées. Les neurosciences et leurs apports récents dans le domaine de l’étude de la décision, donnent un éclairage actuel, « biologique » et intéressant sur la décision, réhabilitant surtout le rôle de l’émotion (3).

1. l’hypothèse de la rationalité dans la décision

1.1. De l’homo oeconomicus

On attribue parfois ce modèle à Adam Smith même si c’est vraisemblablement Pareto qui aurait le premier employé ce terme, en 1906. L’homo oeconomicus ne retient que son intérêt personnel pour prendre sa décision, il cherche à maximiser son bien-être et gère ses ressources dans le seul but de maximiser son utilité globale. Cette théorie constitue une des bases de la science économique car elle s’applique quelle que soit la situation (certitude ou incertitude). L’homo oeconomicus va comparer les alternatives et faire des choix cohérents qui vont impliquer des coûts. Le gain obtenu va compenser le coût d’opportunité. Un bon exemple actuel pourrait être pris à travers les sites de vulgarisation de trading où l’on propose à des apprentis traders, sans explication sur le marché, de « jouer » à la hausse ou à la baisse en prenant quelques risques...pour générer des gains.

Von Neumann et Morgenstern ont montré en 1952 que les individus, dans leurs choix, suivent 5 axiomes de rationalité, en cherchant à maximiser l’espérance mathématique d’une fonction dite d’utilité (ordinale). Il va donc ordonner ses choix.

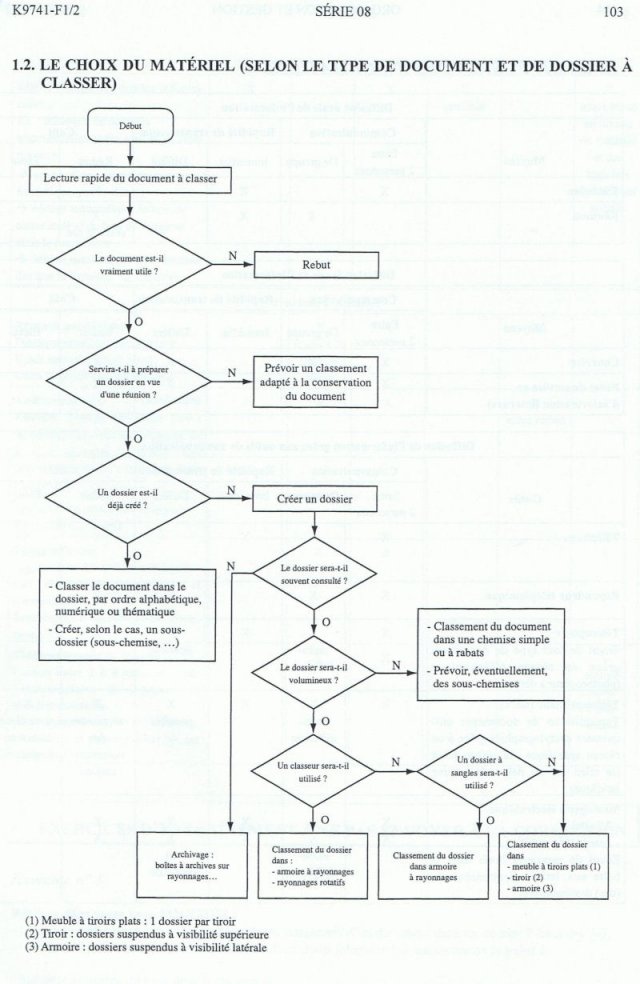

Ce modèle a souvent été défendu par des économistes néoclassiques, car il semble représenter un des fondements du capitalisme, mais aussi par sa simplicité. Robert Solow rappelle en 2001 la faiblesse des modèles alternatifs et l’intérêt d’une approche permettant une économie de moyens. Ce modèle vise à prendre la décision optimale, à travers des modes opératoire ou grilles d’analyse assez simple. On pourrait l’illustrer avec les procédures de secourisme ou de sécurité qui résultent de modes opératoires appris par des instructeurs (on parle d’instructeur de secourisme et d’instructeur militaire) de façon à identifier quelques problématiques récurrentes et les décisions « parfaites » qui doivent être prises. Ces processus sont représentés à l’aide de schémas de type logigramme et valident l’idée qu’il n’existerait qu’une seule bonne réponse à un problème donné. Le domaine de la normalisation en a fait un usage important, pour les besoins de la certification. Voici un exemple de logigramme, fondé sur une approche binaire (réponse par oui ou non à des questions simples) :

Source : Source Wikipédia « L’organigramme de programmation »

Ce modèle simple a essuyé de nombreuses critiques. On l’attribue souvent à Adam Smith en oubliant que celui-ci a développé une approche sociale du comportement. Les sociologues ont ainsi opposé l’homo oeconomicus à l’homo sociologicus qui décide en fonction de ses conditionnements (éthiques, moraux, cognitifs...). Le rôle de l’environnement est mis en avant. R. Boudon parle d’individualisme méthodologique contextualisé, mais il est impuissant à expliquer nombre de décisions.

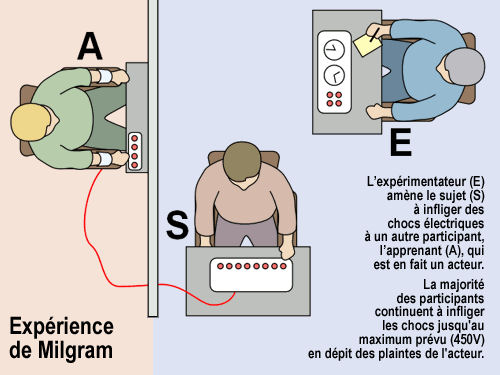

Les psychologues ont démontré dans les années 70, l’incohérence de ce modèle. La fameuse expérience de Stanley Milgram, popularisée par le film de Verneuil « I comme Icare » a démontré le pouvoir de la suggestion, du conditionnement et de la soumission à l’autorité. L’individu, soumis à une autorité qu’il croit légitime, va prendre des décisions qui s’opposent à sa conscience, par obéissance (celle de donner la mort à d’autres humains).

Source : http://rocbo.lautre.net/spip/spip.php?article553

La principale limite est dans la théorie qui suppose la possibilité de calculer des probabilités alors que dans de nombreuses situations actuelles de décisions, les probabilités de résultats sont inconnues. La quasi-disparition des services de planification dans les entreprises et dans les administrations en est la meilleure illustration.

Le courant marxiste a également sévèrement critiqué ce modèle qui ne tient pas compte des conflits d’intérêt et de leur poids dans la prise de décision. L’école politique les mettra plus tard en exergue.

Le courant psychiatrique critique également ce modèle en introduisant une autre dimension : celle des pulsions et des passions. « L’homo demens » pourrait expliquer quelques comportements subversifs voire suicidaires, à l’opposé de tout calcul.

Enfin, plus récemment, les neurosciences ont démonté définitivement ce modèle en démontrant le rôle primitif du cerveau : prendre des décisions rapides, pas forcément exactes. Ce qui conditionne la survie de l’espèce humaine, c’est plus l’adaptation à l’environnement du fait de cette rapidité. Là encore, la bourse fournit de nombreux exemples de décisions ultrarapides, pas forcément exactes (parfois fausses !) prises en fonction de mécanismes non étudiés par l’école de la rationalité (émotion, intuition...). Devant ces critiques, certains auteurs ont cherché à adapter le modèle pour qu’il corresponde à certains types de décisions.

1.2. …à l’hypothèse de la rationalité limitée (Simon)

Dans les années 70, les théories de l’organisation ont largement apporté des éléments au débat sur la décision. En revenant sur les travaux portant sur la rationalité, Herbert Simon crée une véritable « école de la prise décision ». Il cherche à montrer de manière scientifique que l’individu ne dispose pas des éléments nécessaires pour prendre une décision optimale. Il cherche à montrer que l’individu va retenir la solution « parmi les meilleures possibles, mais plus nécessairement optimale au regard de la rationalité réelle ». En fait, il s’agit de mettre en place un processus de rationalisation que l’on a souvent réduit à 3 phases : IMC (intelligence/modélisation/choix). Si cette réduction permet des raccourcis simples pour certains élèves, elle ne pouvait, à elle seule, représenter l’ampleur des travaux de Simon (qui lui valurent le prix de la banque de Suède en 1978, dit « prix Nobel »). Son principal apport a été de travailler sur l’information imparfaite qui caractérise la situation de tout preneur de décision. Son approche est donc très réaliste et facile à illustrer. Ce sont dans les caractéristiques de l’individu que l’on trouve les limites de la rationalité optimale, car nous ne pouvons intégrer une trop grande dose d’informations. Par exemple, le processus de choix devant le (très vaste) rayon de lessives d’un hypermarché va résulter d’une approche combinant plusieurs éléments :

- Un apprentissage préalable : l’individu est modelé par ses expériences passées,

- Une mémoire : qui va permettre de se remémorer le processus de décision antérieure en situation analogue,

- Une habitude : qui va prendre la forme de réflexes face à une situation donnée, sorte de « comportement automatique »,

- Un stimulus positif : le flux d’informations reçu par l’individu va l’aider à décider (exemple des têtes de gondoles ou de la publicité dans l’acte d’achat).

Le système de prise de décision est donc simple et « procédural ». Le « satisficing » est un modèle créé par Simon pour l’illustrer. Il s’agit pour l’individu d’examiner les solutions potentielles l’une après l’autre et de choisir celle qui satisfera à tous les critères.

L’application de ses travaux en management a été (et reste toujours) très importante. Simon a ainsi préconisé la séparation de la prise de décision entre agents et services ainsi que la délégation de la prise de décision à certaines instances.

En réduisant les travaux de Simon au simple « I/M/C », on oublie la prise en compte de la psychologie des individus dans la décision. Il met ainsi en lumière le rôle de la loyauté et de l’investissement personnel dans la prise de décision.

Il détecte également des différences profondes suivant l’environnement et sa lisibilité, quant à la prise de décision ; ce qui donnera une différenciation entre décisions structurées (programmées ou non) et non structurées.

1.3. Limites : le modèle du décideur émotif

C’est justement dans les décisions non structurées que l’on va trouver la première limite aux travaux de Simon. Comme il n’y a pas de règle de décision, le dirigeant va le plus souvent faire appel à des experts ou à des conseillers pour préparer la décision. Notre histoire économique et politique est malheureusement traversée par de très nombreuses décisions prises à contre temps ou en dépit du bon sens élémentaire.

En effet, les agents trient de leur propre chef l’information qui leur parvient et l’interprète ce qui constitue un biais possible, l’exemple malheureux de certaines décisions de trading ou de consulting peut l’illustrer. Ces biais sont d’autant plus importants que la personne est « formatée » par une façon préconçue d’analyser ou de juger. Les matrices d’analyse de certains cabinets de conseil ont ainsi souvent montré leurs limites.

La complexité et le nombre importants d’informations limitent également ce processus.

C.E. Lindblom (professeur à Yale et spécialiste de l’incrémentalisme) l’explique ainsi : « J’identifie tout à fait la »rationalité limitée« de H. Simon à son idée que, lorsque les problèmes deviennent trop complexes, nous franchissons les frontières de la rationalité. » Selon lui, si on a trop de choses en tête, on ne parvient pas à les gérer. Il faut en diminuer le nombre. En diminuant le nombre, on entre dans un espace de rationalité dont on sort si le nombre est trop important.

Le cloisonnement organisationnel constitue aussi une limite à la prise de décision rationnelle, car il instille une vision fragmentée, parfois représentative des intérêts d’un groupe et non de la collectivité. De plus, toute décision requiert un certain niveau de compétence et on a bien souvent confié des décisions importantes à des agents qui ne le possédaient pas (quelques erreurs très couteuses en vies humaines auraient pu être évitées avec des généraux compétents lors de la première guerre mondiale).

Enfin le modèle souffre de ne pouvoir expliquer les phénomènes d’innovation et de changement brutal puisqu’il repose sur une hypothèse selon laquelle les décisions sont conditionnées par les structures et procédures existantes. Enfin, il ne prend pas en compte les jeux d’acteurs et les stratégies politiques des groupes pour imposer une décision. A ce niveau, certains chercheurs se sont focalisés sur les décisions absurdes comme principal biais à l’approche de la rationalité organisationnelle. Christian Morel a consacré un ouvrage aux décisions absurdes (« les décisions absurdes, sociologie des erreurs radicales et persistantes » chez Folio en 2002). Il s’est demandé comment les individus peuvent prendre des décisions radicalement opposées aux buts recherchés. Pourquoi des avions détournés à la suite d’un violent orage font-ils demi-tour pour reprendre la trajectoire initiale alors que la réserve de carburant est insuffisante (et va les conduire au crash) ?

Il définit la décision absurde à travers l’étude de 12 cas dont le célèbre crash de la navette Challenger ou le choc entre 2 pétroliers. Il relève 3 biais : cognitif, collectif et téléologique.

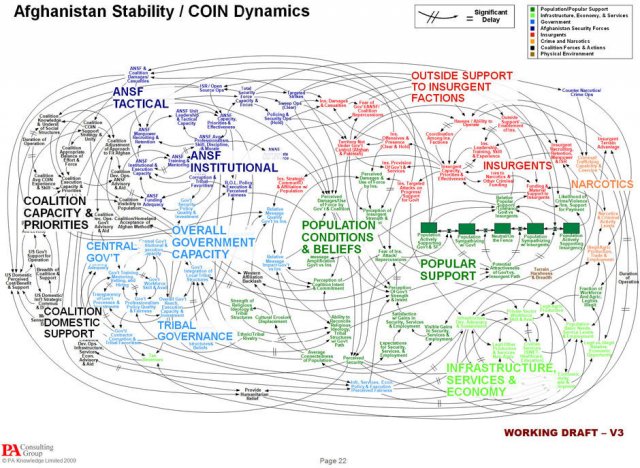

Au niveau cognitif, l’entreprise se contente de « bricolage cognitif » car elle veut le plus souvent aller vite dans la prise de décision. On a souvent reproché ce travers aux décisions prises suite à des présentations « PowerPoint » épurées et simplistes, ne permettant plus la réflexion de fond et la contradiction. Un très célèbre « Powerpoint » a été conçu par des « experts », sur une « modélisation » du conflit en Afghanistan et les hypothèses de résolution. L’actualité nous démontre l’inefficacité de cette « modélisation ». « Le pire ennemi du pentagone s’appelle PowerPoint » titrait d’ailleurs le Courrier international du 25/05/2010 !

Les biais cognitifs amènent donc à des décisions absurdes comme dans le cas de l’explosion de la navette Challenger où un a priori sur le climat de Floride a empêché de mener des études préalables de l’effet du froid sur la défectuosité des joints (qui ont causé l’explosion).

Le biais collectif est assez facile à expliquer car il constitue une des problématiques majeures du management : comment prendre une décision collective ? L’auteur distingue 3 types d’acteurs (le manager, l’expert et le candide) et 5 actions possibles (produire l’erreur, demander l’absurde, suivre l’absurde, être absent et s’opposer). En combinant les différentes possibilités (par exemple, manager produisant l’erreur, expert absent et candide opposant), on trouve différentes situations d’erreurs produites. L’absurdité peut donc être conflictuelle (on s’évertue dans l’absurde malgré l’opposition de certains) ou consensuelle. L’erreur peut ensuite persister dans le temps ou être justifiée par les experts ou, à l’inverse, par « auto expertise » (on pense pouvoir se passer des experts).

Les instances de coordination peuvent aussi générer des erreurs, de par leur mauvaise organisation ou une maîtrise incertaine des outils. On sait par exemple que c’est la mauvaise qualité des conférences téléphoniques qui a atténué les signaux d’alerte de certains dangers dans le cas de la navette Challenger.

Le dernier biais est téléologique ; la perte du sens générant l’erreur. Les décisions n’ont pas d’autres buts ultimes que celui d’agir, c’est le syndrome du pont de la rivière Kwai où un général anglais prisonnier s’évertue à construire un pont pour l’ennemi, sans autre but que de construire le pont ! Dans un ouvrage très pertinent, Christine Kerdellant est revenue sur une douzaine de types d’erreurs célèbres du management (« le prix de l’incompétence » éditions Denoël). Elle commence son livre par la fameuse citation du baron Bich : « un patron, ça prend 7 bonnes décisions pour 2 foireuses et une carrément mauvaise »). On reliera avec bonheur la genèse du système de réservation de la SNCF, Socrate, qui provoqua des blocages monstres, ou bien tout le chapitre consacré à l’illusion d’un consommateur unique (« le mirage du consommateur mondial ») qui a fait perdre tant d’argent à certaines grandes entreprises (Danone, Renault, Disney...). A travers de nombreux articles et travaux, force est de constater que les méthodes rationnelles, en particuliers celles appliquées dans les organisations (la fameuse rationalité organisationnelle de Simon) présentent des biais importants.

Avec la multiplication des informations et la complexification des relations entre les entreprises, on a cherché à développer des approches d’abord composites puis alternatives pour expliquer la prise de décision.

2. Des approches composites aux approches alternatives

2.1. Des approches composites

L’incrémentalisme logique est une description réaliste des processus de décision qu’on doit à Quinn et Senge. L’approche est centrée sur le dirigeant qui doit être « habile ». La décision est le fait de plusieurs sous-groupes en situation de « jeu » et qui s’appuie sur des schémas logiques. Les sous-systèmes sont en phase comme il est postulé dans l’approche système chère à Peter Senge (« la danse du changement » 1999) et la décision se prend « naturellement ». On parle d’incrémentalisme car la décision est fractionnée en une série de choix partiels, avec un mélange de rationalité et d’approche informelle. Quinn propose même un mode opératoire en 3 phases (lancement, activation de la décision et consolidation).

L’incrémentalisme cognitif est une variante de la première approche. C’est une approche de décision « pas à pas » mais fondée ici sur les cognitions en vigueur dans les entreprises, le plus souvent collectives. Nous sommes en présence d’une approche collégiale qui postule que l’organisation est un ensemble de croyances et d’hypothèses tenues pour vraies. Certains « rites » des entreprises peuvent s’expliquer ainsi, surtout dans les organisations à forte culture d’entreprise. La structure cognitive agit comme un filtre entre l’environnement et l’organisation pour la prise de décision. Le mode de prise de décision de certains cabinets d’audit est paradoxalement souvent explicable par cette approche, les croyances et mythes se structurant très en amont (appartenance aux mêmes réseaux et écoles).

Cependant, ces approches sont parfois limitées.

On reproche souvent à l’incrémentalisme une sorte de « dilution » voire d’absence de buts précis. C’est parfois même la volonté du dirigeant pour qui la décision ne servira qu’à expliciter l’action. Le dirigeant sélectionne les réponses qui lui paraissent pertinentes même si les orientations initiales ne sont plus respectées. On retrouve alors de nouvelles orientations, qu’on qualifie le plus souvent de « stratégies émergentes » (Mintzberg).

Quant à l’incrémentalisme cognitif, il a souvent montré ses limites par une forme de « myopie » dans l’analyse des décisions, due à un filtrage trop particulier du réel. Les dérives des agences de notation ou les décisions absurdes de certains cabinets de consultants ne font qu’illustrer cette limite. La fameuse affaire des « avions renifleurs », canular monté de toutes pièces et qui a maintenu l’illusion que l’on pouvait détecter de manière aérienne les nappes de pétrole, en apporte une belle (et coûteuse) illustration.

C’est plutôt dans une approche politique que l’on va trouver les modèles alternatifs les plus solides, en particulier avec les travaux de Cyert et March.

2.2. La mise en avant des comportements d’acteurs : l’école politique (Cyert et March) et l’approche socio-cognitive

Pour dépasser l’approche de Simon et intégrer le facteur comportemental, Cyert et March remettent en question l’hypothèse de la décision optimale. Ils considèrent l’entreprise comme une organisation complexe soumise aux pressions de multiples coalitions. Leur ouvrage : « A behavioral theory of the firm » insiste sur le facteur comportemental. On appelle ainsi leur approche « modèle politique et comportemental ». Les problèmes sont traités les uns après les autres, à chaque niveau (on parle alors de rationalité locale). Ainsi les objectifs sont issus des négociations, donc des jeux de pouvoir. Cette approche a le mérite d’être pragmatique et peut assez facilement se vérifier dans les pratiques managériales de nos entreprises. Le critère de choix d’une action n’est donc pas sa contribution à la satisfaction d’objectifs préexistants mais bien le degré d’accord qu’elle suscite. On peut trouver une belle illustration de cette approche pour certaines décisions prises dans des grandes multinationales issues de grosses fusions et mélangeant différentes cultures nationales (EADS, L’Oréal, Daimler- Chrysler avant la cession de Chrysler).

Mintzberg étudie les différents « jeux politiques » qui traversent les décisions dans les organisations. Les jeux de construction d’empires permettent à des groupes de confisquer une partie du pouvoir et d’obtenir un domaine réservé. Les jeux d’insoumission se rencontrent plus dans des situations de conflit et les jeux du changement au sommet concernent plutôt la modification des équilibres de pouvoir dans l’entreprise.

Une autre approche s’est développée dans les années 80, postulant que ce sont des régulations d’ordre social qui amènent l’individu à raisonner. Les informations traitées sont dotées d’un statut social et ne constituent pas de simples données neutres ; elles sont chargées d’une valeur symbolique et ne « pèsent » pas de la manière dans la décision. Elles peuvent être activées ou inhibées par des variables sociales, provoquant des certitudes ou des conflits. Certains auteurs considèrent que les représentations sociales constituent « un guide pour l’action »(Abric, 1994). Toute cognition est donc sociale (Forgas, 1983), en opposition aux modèles rationnels de base qui lient les éléments de manière logique et démonstrative, en oubliant d’intégrer les interactions sociales. En réalité, l’action stratégique relèverait plus d’une approche système dans laquelle la réalité sociale aurait influencée les individus en termes de comportements. Là encore un bon exemple apparait à travers les comportements des cadres supérieurs de certaines grandes entreprises, aux décisions modelées par leurs parcours, leurs représentations et les « filtres » provoqués par une vision souvent unique du management (apprise dans la même école, partagée par leurs pairs...). La décision des cabinets de conseils « d’ouvrir » leur recrutement à des profils « atypiques » en constitue l’illustration.

Cependant, ces modèles ne sont pas toujours efficaces en termes de décision et leur portée est parfois limitée.

Leur utilisation est complexe et leur modélisation quasi impossible. Ils négligent la portée des éléments fédérateurs des organisations (valeurs, culture...).

Même si le modèle peut intéresser car il nous montre l’importance des interactions dans la décision et peut expliquer certains changements de cap ; il reste contestable. Il requiert beaucoup d’informations et devient donc complexe et peu opérationnel. De plus, ses ressources (financières, humaines) sont liées à d’autres décisions. Enfin, il ne peut expliquer certaines décisions spontanées, qui semblent nées du hasard.

Devant le manque de cohérence de ce modèle et l’aspect restrictif des théories de la rationalité, une école aux postulats radicalement opposés est apparue, se positionnant comme une alternative aux approche classiques : le modèle de la poubelle (ou garbage can).

2.3. Le modèle de la poubelle : une remise en question complète des modèles classiques

March, Cohen et Olsen ont élaboré ce modèle après une étude sur le fonctionnement des universités américaines, en 1972. Ils présentent certaines organisations comme des « anarchies organisées » dans lesquelles se rencontrent des flux indépendants, par hasard. Dans ces organisations, le processus de décisions ressemble à des poubelles dans lesquelles on a jeté de nombreux éléments qui se rencontrent de manière fortuite. Certaines opportunités de choix rendent possibles les prises de décision : ce sont des comités, réunions, conseils dans lesquels des acteurs différents se rencontrent.

Le contenu des « poubelles » est fait des problèmes que les participants souhaitent voir pris en compte. Certains autres participants vont apporter des solutions à travers des projets personnels, idées de développement. Ce modèle séduit car il apporte des solutions parfois innovantes dans des situations de blocage après tentative de résolution par des méthodes rationnelles. Ce modèle postule qu’une décision ne peut s’expliquer que parce qu’on envisage l’ensemble des problèmes et solutions possibles. Les structures formelles ou informelles dans lesquelles les flux sont gérés sont des lieux de débat fondamentaux.

Cependant, l’idée même de décision disparait, mettant en avant plutôt certaines actions, au détriment de décisions réelles. Parfois donc l’organisation peut se retrouver en situation de blocage, de confusion voire d’illusion de décision (car elle agit, mais mal). De plus, comme toute approche anarchique, elle n’est pas modélisable et semble difficile à expliquer, voire justifier.

En situation de « garbage can » la théorie behavioriste de décision ne s’applique plus vraiment : Ainsi, il ne s’agit plus de résoudre des problèmes par des solutions mais de trouver des problèmes à des solutions (tendance à aller vers des problèmes auxquels on peut apporter des solutions). Certains problèmes ne sont pas résolus et « errent » d’une occasion de choix à une autre (Parkinson), ce qui bloque le processus de décision.

Ainsi est-on passé d’une approche où l’on cherchait absolument à maîtriser l’information en vue de prendre la décision optimale, à d’autres approches qui permettent une prise de décision plus contextualisée et plus difficilement modélisable.

Dans les années 90, de nombreux chercheurs se sont focalisés sur des décisions rapides, qui semblaient difficiles à expliquer. Un courant a alors émergé, autour d’une approche plus « humaine » de la décision, centrée sur des mécanismes plus difficiles à expliquer et que les neurosciences ont cherchés à explorer.

3. des approches « humaines », des neurosciences au rôle de l’émotion dans la décision

3.1. La neuroéconomie, une approche récente, centrée sur la décision et ses explications

Le courant de la neuroéconomie est né de la collaboration d’économistes et de neuroscientifiques, dans la mise en place d’expériences nombreuses sur les choix faits par les agents, en particuliers les consommateurs et les décideurs. C’est, à la fois, la remise en cause de modèles classiques de la décision et l’apparition de l’IRM (imagerie par résonance magnétique), qui a permis ce développement. On a donc parlé d’économie « comportementale », car ce courant cherche à mesurer l’effet des facteurs psychologiques dans la prise de décision. La neuroscience serait donc au service de l’économie (Camerer « neuroeconomics : how neurosicence can inform economics », journal of Economic Litterature, Mars 2005). L’expérience de Sanfey est restée célèbre et a démontré l’intérêt de cette approche, il s’agit du « jeu de l’ultimatum ». Un premier joueur dispose de 10 euros qu’il peut partager avec un second joueur, la seule contrainte étant que si le second refuse l’offre du premier, ils sont perdants tous les deux. L’offre acceptée se fera aux conditions prévues par le premier joueur. L’IRM a démontré que des offres perçues comme trop basses et rejetées par le second joueur impliquent une zone du cerveau, l’insula, habituellement associé au dégoût et à la nausée. C’est comme si la perception de la non réciprocité était traitée systématiquement par le cerveau de manière négative, voire comme une punition. D’autres jeux développés par les chercheurs ont donc montré le rôle de la perception et des sentiments sur la prise de décision et les comportements. Certains jeux ont montré le rôle du noyau caudé, siège de la satisfaction et de la récompense dans le cerveau (« jeu de la confiance », de Quervain, Institut de Recherches Empiriques en Economie de Zurich en 2003). Dominique de Quervain démontre que la punition d’un partenaire qui fait défection devient une source de satisfaction pour le sujet qui active des aires du cerveau habituellement associées au traitement de la récompense. La coopération induit donc un bénéfice global pour le groupe social mais a un coût pour les individus qui coopèrent. Un des enseignements de ces expériences montre que l’action de punir un individu asocial reste un comportement socialement rentable et qui utilise les circuits neuronaux du plaisir.

Les chercheurs se sont donc demandés comment décoder les intentions d’autrui et donc valider ou compléter la théorie des jeux qui postule que les individus peuvent prédire les actions des autres. La prise en compte de l’empathie et de l’affect des « joueurs » permet d’approfondir le modèle de la théorie des jeux. Schelling (prix de la banque de Suède 2005) a donc étudié les phénomènes de coordination pure entre les individus et précisé l’explication cognitive. Les joueurs développent une sorte de hiérarchie cognitive basée sur des métas représentations. La neuroéconomie met aussi en exergue le point de vue collectif et permettrait d’expliquer certaines « illusions managériales » qui ont provoqué de graves erreurs dans les prises de décision (engagements militaires, crash de Challenger...). Une étude très actuelle a cherché à démonter l’intérêt de l’IRM dans l’analyse de nos représentations économiques. Elle porte sur notre approche de la monnaie et de sa validité. L’IRM montre notre aptitude à catégoriser très vite et à reconnaître la validité d’une monnaie. La neuroéconomie nous permet donc de comprendre les mécanismes qui ont permis notre adaptation dans un environnement économique complexe. Le management s’est très vite « emparé » de ces approches pour expliquer les comportements des individus en entreprises, principalement sur le thème de la motivation. Un indicateur très en vogue dans l’analyse comportementale, le MBTI (Meyer Briggs Type Indicator) illustre cette approche en cherchant à modéliser des typologies d’individus (16 au total). L’orientation de l’énergie, les modes de perception, les critères de décision et les styles de vie servent à déterminer ces types et montrent l’importance des structurations biochimiques de notre cerveau sur nos motivations et comportements.

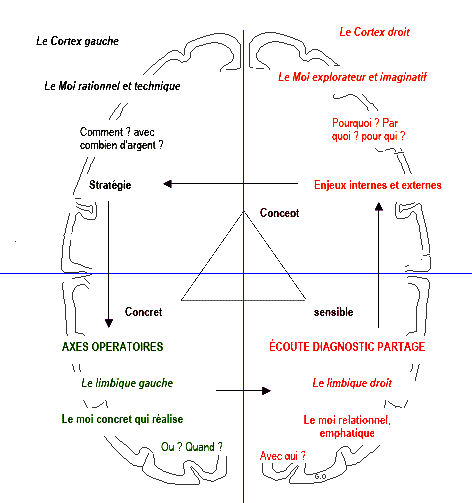

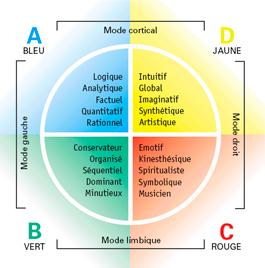

Notre cerveau (1 500 grammes et 2 200 cm carrés de surface développée) possède une centaine de neuromédiateurs circulants qui excitent ou inhibent la réaction d’un organisme à des stimuli externes ; nos neurones se reconfigurent en permanence sous l’influence des stimuli. Le nouvel équilibre ainsi obtenu (et sans cesse remis en question) est appelé l’homéostasie. De nombreux développements ont donc été consacrés à la prétendue « dichotomie » de notre cerveau (gauche et droit) permettant de réserver des types de traitements plutôt aux tâches rationnelles (cerveau gauche) ou affectives et créatives (cerveau droit). L’intégration des trois systèmes (reptilien, siège des réflexes, limbique, de l’affectif et cortical de la réflexion) génère 4 quadrants. Ned Hermann a démontré l’intérêt de cette approche qui permet de présenter 4 modes de décisions suivant le quadrant utilisé :

- Le limbique gauche : plutôt analytique,

- Le cortical gauche : plutôt rationnel et logique,

- Le limbique droit : plutôt interpersonnel et affectif,

- Le cortical droit : plutôt intuitif et imaginatif.

Source : http://www.vivreurope.org/images/cerveau.gif

Ce modèle a trouvé de nombreuses applications en management, en particulier pour composer les équipes « équilibrées » et complémentaires sur des projets ou comprendre pourquoi certaines décisions malheureuses avaient été prises (une équipe composée entièrement de membres fonctionnant sur le même mode cérébral). En fait, de nombreux cabinets de conseil proposent des tests pour évaluer comment on utilise ces 4 quadrants, c’est à dire comment on perçoit et on résout un problème en nous servant de notre cerveau :

Source : http://www.avantage-rh.com/article-h-b-d-i-les-preferences-cerebrales-de-ned-herrmann-64186064.html

Une autre approche, complémentaire, celle de la lignée phylogénique, permet d’expliquer nos comportements à travers notre construction neuronale (Fradin et Le Moullec, 2006). Nous posséderions une personnalité primaire qui alimente nos idéaux de vie, une personnalité secondaire qui agit à partir d’éléments émotionnels accumulés et aussi une personnalité motivationnelle.

Cette dernière permet de nous projeter dans l’action et la décision par un phénomène de « combustion » (association d’une énergie avec un contenant et un contenu motivationnel). La motivation serait un état latent à déclencher par une mise en situation. C’est donc le contexte qui serait déclencheur. L’individu qui se connait pourrait donc mieux décider et réagir face à une situation (une sorte de sixième niveau de la pyramide de Maslow).

Déjà dans les années 90, Damasio démontrait que les décisions sont des réactions à des états cognitivo-émotionnels (peur, plaisir, doute, défi...). Il est considéré comme un des premiers auteurs de ce courant, démontrant l’importance des émotions sur le processus de prise de décision (« l’erreur de Descartes » par Damasio en 1994). Cette approche a séduit de plus en plus de chercheurs, les publications sur ce sujet passant de 8, en 1994, à plus de 1 500 en 2010. Le marketing et le management les ont le plus utilisées, on se souvient de la fameuse sortie du PDG de TF1 expliquant qu’il vendait, à travers la publicité TV, « du temps de cerveau humain disponible » ! Le neuromarketing a ainsi cherché à « localiser » l’aire du cerveau responsable de la décision d’achat, ce qui a donné lieu à de nombreux travaux et à des applications dans le domaine du marchandisage en grande distribution. Le premier cours de neuroéconomie est apparu en 2005, en MASTER de neurosciences à l’université d’AIX-MARSEILLE. Le congrès annuel de l’association française de Sciences Economiques lui est même consacré en 2007. Cependant, ce sont les américains qui restent les pionniers et les plus prolixes dans le domaine, les européens demeurant plus circonspects. Le MIT y consacre une chaire, ainsi que Princeton University (Center of the Study of Brain, Mind and Behaviour) et New york (center for neuroeconomics). La France n’est pas en reste avec un département à l’ENS (département d’études cognitives) ou à Aix (laboratoire de neurobiologie de la cognition). Sacha Bourgeois-Gironde a étudié le cerveau des traders pour tenter une explication des décisions risquées. L’expérience portait sur des traders confrontés à une prise de décision mettant en jeu trois produits financiers différents. Sans information sur la qualité des produits (sauf des rendements différents durant l’expérience), les traders devaient se livrer à 200 prises de décisions. Deux aires cérébrales sont activées : le noyau accumbens, siège des récompenses et l’insula, siège du dégoût. Kuhnen et Knutson démontrent que le noyau accumbens s’active avant que le trader choisisse, dans le cas d’une action. C’est pour une obligation que l’insula sera activée, précédant un choix sans risque. On parle même « d’algorithme interne » pour le cerveau du trader, avec la prise en compte des émotions. En effet, il est courant de penser qu’en trading, les émotions doivent céder place à la rationalité.

Le cas fâcheux des pertes abyssales générées par des traders a également été étudié.

Un ancien trader à Wall Street, devenu neurophysiologiste, a enregistré en direct dans une salle d’échanges de la City à Londres, les variations hormonales de traders. Il a démontré que les concentrations de certaines hormones comme la testostérone ou le cortisol, respectivement liées à la motivation et au stress, fluctuent avec la volatilité du marché. Ces résultats complètent les recherches du MIT, qui avaient montré que l’augmentation des réactions émotionnelles des traders les plus expérimentés face à des événements financiers aléatoires étaient plus faibles que celles des débutants.

Le cerveau, via le circuit de la récompense, a tendance à gratifier le comportement d’investisseur preneur de risques quand celui-ci est face à un choix financier. Or, il a été démontré plus haut que des mécanismes cérébraux et psychologiques différents évaluent les gains et les pertes au cours d’une décision financière. Si, en plus, cette décision doit être prise très rapidement, les risques de pertes peuvent alors subir une pondération moindre par rapport aux gains. Le sur optimisme trouverait donc son explication dans la neurophysiologie.

On comprend mieux comment la perte initiale d’un milliard d’euros occasionnée par le trader Jérôme Kerviel a été multipliée par cinq à cause d’une cascade de décisions prises trop rapidement et sous le coup de l’émotion pour couvrir le plus rapidement possible les erreurs commises. La décision n’est donc pas un processus purement rationnel, simple calcul de probabilité ou d’utilité. Une part de l’instinct inscrit dans la partie profonde de notre cerveau persiste dans le mécanisme de la décision. Trois composants, l’émotion, la cognition et l’action jouent un rôle dans la décision, les neurophysiologues ont cherché à les localiser dans le cerveau mais les recherches ne montrent pas encore comment se combinent ces composantes et leurs interactions exactes. Dans la décision, le passé (par la mémoire), le futur (par l’anticipation) et le présent (par l’analyse du contexte) se combinent de manière complexe. La décision reste, pour les neurobiologistes, ancrée dans l’espace, c’est à dire dans une partie du cerveau : l’hippocampe. Cette partie du cerveau fournit un cadre spatial à la décision, d’où l’importance parfois prise par la posture ou la « mise en scène » pour décider (certains décideurs ne décident que « debout » ou à certains endroits !).

A l’heure actuelle, un consensus semble émerger sur l’analyse des mécanismes de la décision par rapport au temps disponible. Les neuroéconomistes estiment que la démarche de raisonnement « rationnel » serait incompatible avec un temps de décision limité mais aussi avec nos capacités attentionnelles et mnésiques (mémoire de travail trop faible) également limitées. Mintzberg a démontré que les décisions managériales impliquent d’importantes actions et d’importantes ressources (Mintzberg, 1975), le temps du décideur reste limité ce qui conduit à penser que son information est incomplète voire inexacte lorsqu’il décide ! L’affaire du « sang contaminé » fournit une triste illustration à ce mécanisme, des décisions ministérielles (donc préparées et encadrées) ayant été prises très vite avec des informations incomplètes et contre tout principe de précaution...dictées par l’urgence.

Cependant, une grande partie des économistes, surtout de tendance libérale, rejette cette approche, lui préférant une analyse mathématique qui cherche à modéliser la décision. Les « dérives » lucratives liées à l’utilisation dans le domaine du marketing ou du développement personnel ont décrédibilisé cette approche (voir le livre « votre cerveau et votre argent, comment la neuroéconomie peut vous aider à devenir riche » de Jason Zweig en 2007). Les économistes reprochent également aux neuroéconomistes un risque de « réductionnisme biologique » qui chercherait une réponse unique à des questions complexes de décision (Frydman et Goldberg, « imperfect knowledge economics » Princeton university press). Frydman explique que la clé de la décision n’est pas à trouver dans les émotions mais plutôt dans l’imperfection intrinsèque de la connaissance de la complexité du monde qui les entoure. Le professeur Ehrenberg, au CNRS, explique qu’il ne faut pas faire de confusion entre « l’homme social » et « l’homme biologique », certaines décisions ne pouvant entièrement être expliquées par les programmes d’IRM et leurs interprétations. De plus, ces études coûtent très chères et restent cantonnées à l’étude de cas particuliers.

Un consensus existe cependant, en matière de décision, en relation avec les approches comportementales, pour considérer le rôle fondamental tenu par les intuitions et émotions dans la décision.

3.2. Les apports des neurosciences : le rôle de l’intuition et de l’émotion

Apparemment opposés aux modèles rationnels figurent ceux qui considèrent que la décision est entièrement fondée sur les intuitions. La prise de décision intuitive est abordée de manière très sérieuse dans les années 80 (« Making management decisions : the role of intuition and emotion » Academy of Management Executive, Février 1987). La prise de décision intuitive se fonde sur un processus inconscient qui se nourrit de l’expérience accumulée. En fait, certains auteurs démontrent la complémentarité de cette approche avec l’approche rationnelle, en particulier à travers l’exemple du jeu d’échec ou de la stratégie d’entreprise. Les grands maîtres aux échecs peuvent mener cinquante parties en même temps et les grands stratèges, enchaîner de nombreuses prises de décisions stratégiques dans un temps très court (Minzberg l’a démontré en étudiant l’emploi du temps des dirigeants de multinationales). L’expérience et l’expertise permettent de reconnaître très vite une configuration donnée et d’utiliser le vécu et les données accumulées pour décider (le fameux « effet d’expérience » du management). Huit conditions ont été identifiées par Agor (Agor, « intuition and organizations ») pour savoir dans quelles circonstances un manager avait le plus de chances de prendre une décision intuitive :

- Un niveau d’incertitude élevé,

- L’absence de précédent,

- L’absence de prédiction scientifique,

- Le manque de « faits » tangibles,

- L’incertitude sur la direction à prendre,

- Le manque d’intérêt des données analytiques,

- La présence de plusieurs solutions potentielles plausibles,

- La pression du temps.

Cependant, le manque de « crédibilité sociale » de ce type de décision entraîne les managers à les « enrober » de données faussement cartésiennes pour qu’elles soient acceptables.

Agor a également démontré le caractère spontané de l’intuition, l’exemple célèbre de Mac Donalds peut l’illustrer. Ray Kroc a du se prononcer très vite pour choisir le nom de Mac Donald’s, avec une « mise » avoisinant les trois millions de dollars. Il aurait fermé la porte de son bureau, tout jeté par la fenêtre et dit à son avocat : « je sens au fin fond de moi que c’est une bonne affaire ».

Des recherches actuelles mettent en relation l’intuition et la créativité dans des process de prise de décision, qui font l’objet de séminaires de managers. Il est à noter que l’approche « créative » date des années 70 et qu’elle a été renforcée par les travaux sur l’intuition. Les plus connus utilisent une méthodologie de résolution de problème en quatre phases :

- Préparation : imprégnation du problème,

- Incubation : on interrompt tout effort conscient pour résoudre le problème et on « lâche prise »,

- Illumination : on laisse un élément essentiel de la solution émerger pour résoudre le problème,

- Élaboration : on construit, en confirmant, élargissant, renforçant, reformulant ; pour élaborer une réponse au problème initial (Oxenfeldt, Muller et Dickinson, "basic approach to executive decision making, 1978).

Simon (ce qui est très peu connu) a étudié la prise de décision intuitive dès 1987, permettant à de nombreux chercheurs en psychologie de développer des protocoles de recherche pour mettre en relation l’émotion, l’intuition et la prise de décision (Kahneman en 2003, par exemple). La prise de décision intuitive pourrait se définir comme « le sentiment de savoir avec certitude, sur la base d’informations incomplètes et sans réflexion rationnelle consciente » (Shirley et Langan-Fox, 1996). Une définition récente (2007), présente la prise de décision intuitive comme « un processus rapide et non conscient qui produit des jugements chargés affectivement sur la base d’associations holistiques » (Dane et Pratt, 2007).

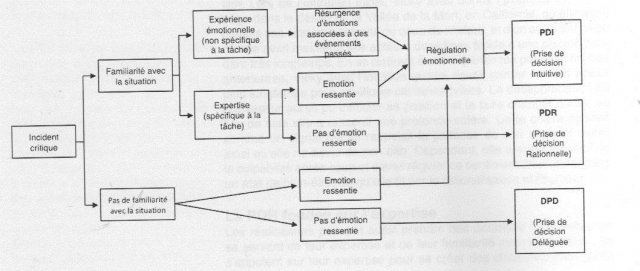

Les chercheurs se sont en particulier intéressés au monde des experts, pour démontrer que l’entraînement intensif générait des « feed-backs » permanents permettant de développer une connaissance tacite spécifique. La décision est souvent prise de façon quasi « magique » (Nonaka, 1995). Le processus est holistique et intègre l’émotion. Celle-ci a été définie de plusieurs manières, principalement par une approche cognitive. Ce processus permettrait à un individu d’évaluer la signification des différents stimuli (internes et externes) au regard de ses préoccupations et objectifs. La décision sera celle qui maximisera au mieux son bien-être (Scherer, 2001). Il s’agit de « l’appraisal theory ». Damasion a démontré également que les individus qui ont eu certaines régions du cerveau endommagées (celles liées à l’émotion), ne pouvaient pas prendre de décisions (Damasion, 1998). Plus précisément, c’est l’amygdale limbique siège du processus émotionnel, qui fournit de l’information au cortex supérieur, siège de la décision (Ledoux, 1996). Un travail de recherche très intéressant a permis d’identifier cinq processus de prises de décision qui mènent à trois types de prises de décision différents (Coget, Haag et Bonnefous, 2009).

Source : « le rôle de l’émotion dans la prise de décision intuitive » Coget, Haag et Bonnefous, revue Management de l’AIMS, 2009

Ainsi, ces différentes recherches permettent-elles d’affirmer qu’en matière de décision, il est important d’utiliser son intuition et d’écouter ses émotions. Même lors des décisions très stratégiques, il est fondamental de prendre en compte ces apports de la recherche, qui prennent d’ailleurs tout leur sens lorsqu’on étudie les principales erreurs managériales stratégiques (Kerdellant, « le prix de l’incompétence », 2000).

Plus récemment, dans le prolongement de la neuroéconomie, apparaît un courant au carrefour de plusieurs disciplines, dont le concept principal est la simplexité et l’auteur le plus connu, Alain Berthoz, professeur au Collège de France. Cette approche se veut « biologique » et humaniste et présente un intérêt certain dans l’étude de la prise de décision.

3.3. Pour une approche humaine et biologique de la décision (simplexité et déterminisme)

Toute la théorie d’Alain Berthoz est fondée sur le comportement et postule que l’humain n’est pas un simple paramètre d’une équation, car son comportement n’est ni tout à fait aléatoire, ni tout à fait prévisible. L’homme a une capacité de simplification qui lui permet de résoudre des problèmes posés par la complexité, ce qui pourrait sembler paradoxal mais s’éclaire à la lecture de l’ouvrage principal d’Alain Berthoz (« la simplexité », Alain Berthoz, Odile Jacob 2009). L’auteur est professeur au Collège de France et codirige le laboratoire de physiologie de la perception et de l’action. Il définit la simplexité comme « l’ensemble des solutions trouvées par les organismes vivants pour que, malgré la complexité des processus naturels, le cerveau puisse préparer l’acte et en projeter les conséquences ». Différents réseaux neuronaux sous-tendent un répertoire d’actions important. Il insiste en particulier sur la modularité du cerveau, sorte de « division du travail ». Le cerveau est également très rapide dans sa prise de décision, surtout en cas de danger imminent ; la réaction motrice anticipatrice que produit un obstacle risquant d’induire une chute se déclenchant en moins de 100 millisecondes ! Alain Berthoz insiste également sur la fiabilité du cerveau et sur sa flexibilité (en particulier dans l’adaptation au changement). Pour résoudre un problème, un organisme doit pouvoir percevoir, capturer, décider ou agir de plusieurs façons pour s’adapter au contexte. C’est le concept de vicariance (processus naturel qui permet à certains organes de prendre la place d’un autre défaillant dans les organismes vivants ; son préfixe « vice » signifie la suppléance, exemple vice-président). En clair, il n’existerait pas une solution unique à un problème donné, avec un seul mode opératoire. De plus, le cerveau mémorise des expériences passées pour les utiliser dans des actions futures ou pour prédire les conséquences futures d’une action. C’est la mémoire qui permet l’anticipation et la prédiction, les informations sensorielles étant traitées par le thalamus. La simplexité se base donc sur un traitement probabiliste et s’accommode de l’incertitude.

Cette analyse de l’incertitude a été rappelée par Robert Branche (« les mers de l’incertitude » Robert Branche, 2011) qui précise qu’un monde sans incertitude serait un monde sans création de valeur. L’auteur fustige les approches simplistes et chiffrées : « le piège des tableaux Excel est qu’ils présentent une représentation rassurante du futur : tout est simple, organisé et prévu ». Il prend l’exemple du designer Stefan Sagmeister qui ferme son agence new-yorkaise pour une année sabbatique, tous les sept ans. Cette année-là, personne ne répond plus au téléphone : l’agence est complètement fermée. Selon Sagmeister, cette pause est nécessaire pour renouveler la créativité et maintenir le niveau de performance En management, on craint l’incertitude dans la prise de décision. Nous sommes d’abord des êtres inconscients mais aussi survivants de par nos réflexes profonds. Ce sont des réflexes de peur, nous sommes programmés. C’est souvent la peur qui génère une forme d’action et de courage (comme le rappelait récemment le regretté Lucien Aubrac, grand résistant français). Longtemps l’incertitude a correspondu à un déficit de connaissances (Laplace).

A l’heure actuelle, nous serions dans un contexte d’incertitude globale. Les humains se sont dotés d’objets qui peuvent alors agir à distance, d’où l’incertitude globale (en relation avec la globalisation).

Le paradoxe du management, selon Branche, apparaît alors : on a longtemps cru que manager c’était réduire l’incertitude. Or manager, c’est s’immerger dans un monde d’incertitudes. Schumpeter ne rappelait-il pas l’importance de la prise de risque dans la démarche de l’entrepreneur ? Dans le monde de l’incertitude, il faut réfléchir à partir du futur et non du présent, ce qui conduit à étudier la démarche de quelques grands « visionnaires » du management (Steve Jobs pour Apple ou Richard Branson pour Virgin, par exemple).

Alain Berthoz présente également une démarche intéressante : celle de la simplexité pour prendre certaines décisions qui sembleraient complexes voire impossible à prendre. Le principe du « détour » induit une forme de complexité accessoire qui facilite la prise de décision. On a donc un ensemble de variables sur lesquelles on peut agir (par exemple position, vitesse et accélération pour la conduite automobile) pour faciliter les décisions de contrôle.

Il prend l’exemple de l’élaboration de l’Airbus A380 qui a entièrement été simulée avant d’avoir été construit. L’ouvrage et les articles d’Alain Berthoz, même s’ils ne font pas référence directement au management, apportent une clarification des processus de décision et une explication « biologique ». Il postule qu’il est nécessaire « d’apprendre à regarder » pour mieux décider. L’apprentissage de séquences de mouvements complexes est possible grâce au cerveau et aux capacités du cortex préfrontal. Lorsque la séquence est acquise, le cortex se « libère » et le mouvement devient « automatique ». Le cortex peut alors établir des liens nouveaux, combiner d’autres éléments et donc prendre des décisions qui peuvent sembler complexes. Le cerveau n’est donc jamais remobilisé par des programmes appris. Une bonne illustration de ce principe se trouve dans l’acte d’expertise qui consiste, pour un expert reconnu, à donner un éclairage spécialisé et à trancher sur un problème complexe. On parle du « regard de l’expert » et on s’étonne toujours de sa rapidité de perception, voire des automatismes qu’il lui est parfois difficile d’expliquer. La conclusion du livre de Berthoz montre toute la profondeur de sa pensée : « la simplexité est subtilité plutôt que rigueur, diplomatie plutôt qu’autorité. Elle est adaptative plutôt que normative et probabiliste plutôt que déterministe. » Selon Berthoz, il n’y aurait pas de forme élevée de processus de décision sans imaginer différentes stratégies et « sortir » de notre corps, c’est à dire se distancier et simuler mentalement des hypothèses. Il prend ainsi l’exemple extrême de l’automate qui est une sorte de simplification de l’humain (avec des gestes programmés) et de sa faible capacité de réaction ainsi que son absence de créativité. On rappelle que des problèmes très difficiles deviennent ainsi très simples à résoudre en utilisant des détours, à condition de les poser autrement, ce qui est une procédure simplexe. C’est donc peut être dans cette approche plus « humaine » que se trouverait les ressorts actuels de la décision. Robert Branche dresse ainsi un parallèle entre le fonctionnement de l’Homme décrit par la neurobiologie et le comportement des organisations.

Il met en évidence qu’on peut modéliser l’entreprise comme un corps social qui, tout comme l’Homme, agit en fonction de ses interprétations, avec des émotions ; et s’appuie largement sur son inconscient pour assurer sa survie et son adaptation à l’environnement (Robert Branche, Neuromanagement, 2008). Dès 2008, il avait fustigé les entreprises et leurs « modèles de décision » basés sur la recherche sans fin du profit ; en insistant sur leur « déconnexion » de l’économie réelle et un certain nombre d’erreurs graves de management. Il postule ainsi que c’est en acceptant cette dimension apparemment irrationnelle des processus émotionnels et inconscients, que l’on peut diriger efficacement.

Ainsi Damasio a-t-il pu expliquer que : « Arriver à une décision demande de posséder des informations relevant de toutes sortes de domaines, et d’être en mesure de leur appliquer certaines stratégies de raisonnement ». Manager la décision consisterait donc à construire des scénarii intégrant l’ensemble des informations pertinentes situées dans l’entreprise, c’est-à-dire à la fois les informations instantanées mais aussi celles relevant de la mémoire de l’entreprise, ainsi que celles captées par les sensations et les émotions. Même si cela reste impossible à modéliser, l’histoire du monde a su montrer que les stratégies de survie ont pu permettre de réelles décisions majeures et que c’est dans notre cerveau (et ses mystères) que figurent les clés de l’explication de nos décisions.

Eléments de bibliographie :

Ouvrages généraux :

- « L’atlas du management » ; AUTISSIER, BENSEBA et BOUDIER, Eyrolles ; 2008 (en particulier la partie 4, « le management des hommes »)

- « Management des organisations » ; HELLRIEGEL, SLOCUM et WOODMAN ; De Boeck ; 2004 (plus particulièrement le chapitre 14, « prise de décision et détermination de l’objectif »)

- « Comportements organisationnels » ; ROBBINS, JUDGE et GABILLIET ; Pearson Education ; 2006 (en particulier le chapitre 5, « perception et prise de décision »)

- « Décider dans les organisations : dialogues critiques entre économie et gestion. » ; Sous la direction de Jean-Robert ALCARAS, Patrick GIANFALDONI et Gilles PACHE

- « Administration et Processus de décision » ; Herbert Alexander SIMON ;ECONOMICA.

- « Les organisations, Etat des savoirs », sous la direction de SAUSSOIS ; Editions Sciences Humaines, 2012 (nombreuses analyses sur les différentes écoles)

- « 100 fiches pour comprendre l’organisation et la gestion des entreprises » ; HOUNOUNOU ; Bréal, 2006

- « 100 fiches pour comprendre le management » ; HOUNOUNOU ; Bréal, 2008

- « La simplexité », BERTHOZ ; Odile Jacob, 2010 (A lire absolument pour la partie 3 !)

- « Faire le bon choix », LERHER ; Robert Laffont, 2010

- « Le génie de l’intuition » ; GIGERENZER ; Pocket Evolution, 2011

- « Les mers de l’incertitude », BRANCHE, Editions du Palio, 2010 (visionnaire !)

- « Neuromanagement », BRANCHE, Editions du Palio, 2008 (la base de la partie 3)

Articles :

- « Qu’est-ce que décider dans une organisation » ? ROJOT, Sciences humaines, Mai 2004

- « L’entreprise face à l’incertitude » ; MOUSLI ; Alternatives économiques 309 de Janvier 2012

- « Humaniser l’homo oeconomicus » ; MOATTI ; Alternatives économique 57 HS de Mai 2003

- « Les décisions absurdes » ; MOREL ; école de Paris du management ; 2001, http://www. ecole.org

- « Discernement et pratiques de décisions » ;BOUGON et FALQUE ; Ecole de Paris du Management ; Avril 2008

- « Théories de la Décision, approches antagonistes ou complémentaires ? » LABARRERE ; Mémoire de Master Première Année Sciences Economiques ; université d’Avignon

- « Le rôle de l’émotion dans la prise de décision » ; COGET, HAAG et BONNEFOUS ; M@n@gement, revue de l’AIMS, 2009

- « Rencontres avec Alain Berthoz. La simplexité : l’art de s’adapter au complexe » ; DORTIER ; Sciences humaines 233, janvier 2012 : http://www.scienceshumaines.com/rencontre-avec-alain-berthoz-la-simplexite-l-art-de-s-adapter-au-complexe_fr_28217.html

- « Les compétences émotionnelle au cœur de la performance individuelle et collective », BELLINGHAUSEN, CNRS et université Paris 5 (passionnant cours sur les neurosciences)

- « L’émotion et la prise de décision », VAN HOOREBEKE ; revue française de gestion ; n°182, 2008 : http://www.cairn.info/resume.php?ID_ARTICLE=RFG_182_0033

- « Neuroéconomie : les émotions dictent-elles nos décisions ? » Article du Monde économie du 15 Janvier 2008, http://www.cns.nyu.edu/ glimcher/LeMonde.pdf (à lire absolument !)

- « La neuroéconomie peut-elle changer l’économie ? » par SachaBourgeois-Gironde1, Institut Jean-Nicod (CNRS-EHESS-ENS). IDEES - revue de Sciences Economiques et Sociales, 27/11/2009(passionnant !) http://hal.archivesouvertes.fr/docs/00/43/67/25/PDF/IDEES_sesplurielles.pdf

- « La neuroéconomie : essentielle, mais pour qui ? » Benoît Dubreuil, Chercheur postdoctoral ; Département de philosophie Université du Québec à Montréal : http://bdubreuil.quebecdoc.com/IMG/pdf/La-neuroeconomie-E_I.pdf (une critique de la neuroéconomie)

Séminaire :

Compte-rendu du séminaire « choisir son cap dans l’incertitude » (auquel participait Robert Branche) : http://ecole.org/seminaires/FS6/SEM631 ; Ecole de Management de Paris, Janvier 2012

Expérience :

http://analyseeconomique.wordpress.com/2011/07/08/les-predictions-du-marshmallow-test/ (la fameuse expérience de l’université de Stanford sur le « self-control » et l’impulsivité, où un enfant est mis devant un Marshmallow avec le choix de le manger ou non, et un gain double en cas de résistance à l’action …).

Interview :

Interview du professeur Damasio (1/11/2010) sur France Culture : http://www.franceculture.fr/emission-continent-sciences-les-sentiments-dans-notre-cerveau-2010-11-01.html

Pour télécharger cet article au format pdf, cliquer sur l’icône ci-dessous :