L’essentiel de la notion

Les internautes accèdent généralement à un site web en faisant une requête sur un moteur de recherche (Google en France à 92 %). Ils consultent essentiellement la première page et en particulier les 3 premiers résultats (58 % des clics) [1] ; le rang du site web parmi les multiples réponses proposées est essentiel. La compréhension du fonctionnement des moteurs de recherche est donc nécessaire pour optimiser ses chances d’apparaître bien placé dans les résultats. La technique est nommée en marketing SEO (Search Engine Optimization) ou référencement naturel. Le fonctionnement d’un moteur de recherche se décompose en deux phases : des robots scrutent le web en permanence, lisant les pages web et les répertoriant dans un index géant. Ils référencent ainsi des milliers de milliards de documents.

La lecture de ces pages, les informations qui vont être retenues et donc le référencement par le moteur de recherche dépendent d’un certain nombre de critères dont l’architecture du site, la qualité et la cohérence de son contenu et la fréquence de mises à jour. Lors d’une requête, l’algorithme va d’une part, établir la correspondance entre ce qui est recherché et les pages web répertoriées dans son index (critères in page) et d’autre part évaluer la popularité des sites à travers les liens entrant (critères off page). Pour Google 200 critères environ, évoluant en permanence, permettent de définir le Pagerank d’une page c’est-dire son classement dans le résultat. Bien qu’il existe aujourd’hui, notamment chez Google, une certaine dose de personnalisation des résultats de requête en fonction de l’historique de recherche de l’internaute, ceci ne remet pas en cause l’intérêt du SEO. Évidemment on ne construit pas un site pour les moteurs de recherche mais pour les internautes qui vont s’y connecter, il est cependant essentiel de faciliter la compréhension du site par les moteurs de recherche et pour cela de respecter un certain nombre de règles d’écriture.

Pour faciliter la phase indexation du site et des différentes pages, il faut en soigner l’architecture. Des robots lisent les pages en surfant de lien en lien et transmettent les codes HTML pour indexation des nouvelles pages ou mise à jour. Il faut donc vérifier qu’il est facile d’accéder aux différentes pages à partir de la page d’accueil par exemple (3 clics maximum). L’existence de liens internes facilite la navigation pour les internautes mais aussi pour les robots. La création d’une page représentant le plan du site peut également faciliter le parcours. Par ailleurs, la fréquence des mises à jour aura un impact sur la fréquence de visite des robots. Il faut donc les habituer à venir régulièrement visiter un site en modifiant régulièrement celui-ci pour que, lors d’une requête, la page proposée soit à jour. La présence dans l’index de Google des différentes pages d’un site peut être vérifiée grâce à la requête « site : www.nomdusite » par exemple (site :www.creg.ac-versailles.fr).

Pour être sélectionné en bonne place lors de la requête d’un internaute (bien positionné), un site doit correspondre au contenu recherché et donc aux mots clefs saisis par l’internaute. Les concepteurs du site doivent donc s’interroger sur les mots clefs qui seront saisis par les internautes, établir une liste de mots pertinents en lien avec l’activité de leur site web, voire le contenu de chaque page. De plus, les mots clefs doivent être suffisamment précis pour limiter le nombre de sites qui leurs correspondent et augmenter les chances de paraître en haut de liste et bien décrire le contenu du site. Si les mots clefs saisis par l’internaute apparaissent dans les champs clefs d’un site mais décrivent mal le contenu réel, l’internaute quittera le site très rapidement (rebond). Au contraire, des mots clefs pertinents attireront une cible plus facile à transformer. Cette liste doit être complétée de mots entrant dans le même champ lexical qui seront également utilisés afin de renforcer la cohérence.

Pour une bonne indexation, le nom de domaine doit à la fois être explicite par rapport à l’activité du site, de même que les URL de chaque page et les titres éditoriaux des pages, mais aussi reprendre les mots clefs des internautes. De façon générale, le moteur de recherche doit « comprendre » facilement quel est le contenu de la page et trouver un contenu cohérent pour pouvoir l’indexer avec pertinence. Des conventions de codage (code HTML) doivent être respectées notamment en matière de titres, de description du site et concernant les balises h1 à h6, qui sont des repères, délimitant des zones pour les moteurs de recherche. Les balises permettent de structurer le contenu d’une page en indiquant les différents niveaux de titre, sous-titre, etc. et les robots lisant en priorité le contenu inclus dans les balises.

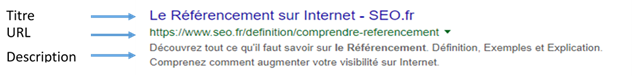

Lors d’une recherche, les résultats proposés (SERP ou Search Engine Result Page) font apparaitre l’URL mais également le titre et la description correspondant respectivement au texte saisi pour la balise titre et la balise méta description (codage HTML). Ces contenus doivent donc donner envie à l’internaute d’accéder au site sans pour autant le décevoir.

Par ailleurs, les liens internes au site doivent être de préférence explicites (indiquer à quoi ils conduisent) et les images doivent être accompagnées d’une description à destination des moteurs de recherche. Les éditeurs en ligne ou les CMS tels que Wordpress proposent de compléter ces différents éléments de façon à optimiser le référencement.

Parallèlement à l’adéquation requête/contenu du site, l’algorithme du moteur de recherche prend en compte la popularité des sites, mesurée à travers l’analyse des liens entrants (backlinks). Le nombre de liens entrants) et surtout la qualité des sites qui ont fourni ces liens ont un impact important sur la popularité. Les meilleurs backlinks proviennent de pages populaires, dans le même domaine d’activité, si possible dans la même langue et surtout naturels. En effet, il ne s’agit pas d’acheter des liens qui n’auraient pas de sens pour les internautes mais réellement de pratiquer le linkbaiting (d’appâter les webmasters des sites populaires) grâce au contenu pertinent créé et de les inciter ainsi à créer un lien pour apporter un complément à leurs internautes. Il est cependant possible de mener un travail relationnel visant à développer le nombre de liens externes pointant vers les pages du site, grâce à des échanges de liens pertinents par exemple. Enfin, la stratégie menée en termes de réseaux sociaux peut également améliorer la notoriété de votre site et indirectement favoriser son référencement même si la popularité d’une page n’est pas directement prise en compte par les moteurs de recherche. Il est donc judicieux de mener, en complément du SEO, une politique d’optimisation des médias sociaux (SMO), consistant à disposer de comptes sur des réseaux sociaux, favoriser la navigation entre site web et réseaux sociaux par le biais de liens ou d’icônes de partage, publier des contenus attractifs sur les réseaux sociaux.

Pistes d’activités en classe autour du référencement

- Brainstorming autour de mots clefs et champ lexical à partir de l’intuition, de l’outil Hot trend de Google, des outils d’autocomplétion ou encore à partir de l’analyse des réponses proposées par Google (mots clefs choisis par les concurrents) ou des recherches associées proposées.

- Analyse du site de l’enseigne de stage (repérer et comparer)

- Titre, url, description affichés par Google ;

- Titre, description… en code HTML en affichant le code source de la page (clic droit).

- Écriture de titres, de descriptions, d’URL de pages.

- Activité d’optimisation sur le site Wordpress créé précédemment

- Analyse du site manuellement ou avec un outil spécifique ;

- Modifications du site (création de liens internes, écriture des descriptifs d’images, réécriture de texte afin d’utiliser les mots clefs sélectionnés).

**Bibliographie

Olivier Andrieu, Référencement Google mode d’emploi, Eyrolles